На конференції Google I/O 2025 компанія анонсувала нову функцію Live Search, яка дозволяє користувачам отримувати інформацію про об’єкти в реальному часі, використовуючи камеру свого пристрою. Ця можливість стане частиною розширеного AI Mode у Google Search та буде доступна в додатку Gemini на iOS.

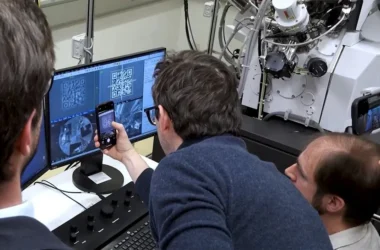

Функція Live Search дозволяє користувачам навести камеру на об’єкт і отримати миттєву інформацію про нього. Наприклад, можна навести камеру на інгредієнти в холодильнику та отримати рецепти страв, які можна з них приготувати. Ця технологія поєднує можливості Google Lens та штучного інтелекту Gemini, забезпечуючи глибоке розуміння візуального контексту.

Live Search буде доступна в бета-версії для користувачів Search Labs у США пізніше цього літа. У додатку Gemini на iOS також з’явиться можливість спільного використання камери та екрана, що дозволить обговорювати з ШІ те, що відображається на екрані пристрою. Раніше ця функція була доступна лише на Android-пристроях, таких як Pixel 9 та Galaxy S25, але тепер вона стане безкоштовною і для користувачів iOS.

Окрім Live Search, Google планує впровадити інші функції в рамках AI Mode, зокрема Deep Search для глибокого аналізу тем, агентів ШІ, які можуть виконувати дії в інтернеті від імені користувача, та нові інструменти для онлайн-шопінгу. Ці нововведення спрямовані на те, щоб зробити пошук більш інтерактивним та персоналізованим, дозволяючи користувачам отримувати відповіді на складні запити та взаємодіяти з інформацією в новий спосіб.