Intel презентувала новий AI інструмент під назвою Computer Graphics Visual Quality Metric для об’єктивного вимірювання якості зображення в сучасних іграх. Про це пише Tom’s Hardware. Інструмент вже доступний на GitHub у вигляді PyTorch-додатку.

Навіщо потрібено вимірювати якість зображення

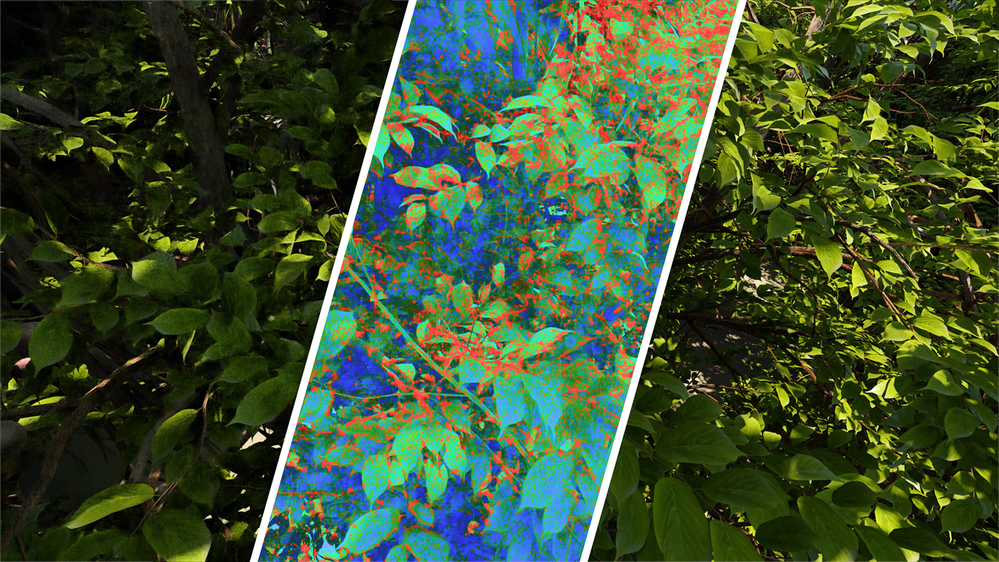

Сучасні ігри майже ніколи не відображають кадри безпосередньо з рендерингу — більшість кадрів проходять через апскейлінг (DLSS, FSR, XeSS), генерацію кадрів, трасування променів або інші методи. Це породжує численні артефакти, такі як:

- “примари” (ghosting),

- мерехтіння (flicker),

- спотворення (aliasing),

- помилки при виведенні об’єктів (disocclusion).

Раніше якість таких зображень оцінювали суб’єктивно або за допомогою неідеальних метрик, наприклад PSNR, що більше підходить для відеокодеків, а не для рендерингу в реальному часі.

Як працює AI інструмент?

Intel представила подвійний підхід:

1. База даних: створено новий набір CGVQD (Computer Graphics Visual Quality Dataset) — колекцію відео з артефактами, притаманними сучасним технологіям рендерингу. Сюди входять:

- трасування променів;

- нейронне згладжування шуму;

- нейросуперсамплінг (DLSS, FSR, XeSS);

- Gaussian splatting;

- інтерполяція кадрів;

- процес застосування шейдингу;

2. AI-модель: спеціально навчена модель CGVQM аналізує відео та присвоює об’єктивний рейтинг якості. Вона враховує широкий спектр візуальних спотворень, які традиційні метрики не фіксують.

З появою CGVQM Intel відкриває нову еру оцінювання графіки у відеоіграх. Завдяки поєднанню якісного датасету та машинного навчання, оцінка якості більше не буде базуватись лише на суб’єктивному сприйнятті. Інструмент уже доступний на GitHub для відкритого використання.