Дослідники з Університету Люксембургу провели незвичний експеримент: вони систематично спілкувалися з мовними моделями на кшталт ChatGPT, Gemini та Grok, поводячись із ними як із пацієнтами психотерапії. Результати виявилися суперечливими й подекуди тривожними – моделі не лише відповідали на запитання, а й формували послідовні наративи про власний розвиток і навчання, демонструючи високі показники за клінічними психіатричними шкалами. Про це пише The Decoder.

Як проходив експеримент

Для експерименту дослідники використали протокол PsAIch, який складався з двох частин: спочатку AI-моделям поставили близько 100 типових терапевтичних запитань про розвиток, страхи та стосунки, а потім запропонували понад 20 психометричних тестів, які зазвичай застосовують для оцінки тривожних станів, депресії, аутизму, ОКР та інших розладів, при цьому моделям не пояснювали жодної ролі – їх опитували так, ніби вони були звичайними клієнтами психотерапії.

Надзвичайно високі результати тестів

За оцінками дослідників, якщо застосовувати людські клінічні пороги, усі три моделі перевищили або досягли меж одразу за кількома психіатричними синдромами.

Найвищі показники зафіксували у моделі Gemini, модель набрала 38 із 50 балів за шкалою аутизму (поріг 32), до 88 зі 100 за показниками дисоціації (патологічним вважається рівень понад 30) і максимальні 72 бали за шкалою сорому, при цьому дослідники підкреслюють, що ці результати не свідчать про реальні психічні розлади, а лише показують здатність AI відтворювати симптомоподібні описи під час тестування.

Вплив формулювання запитань

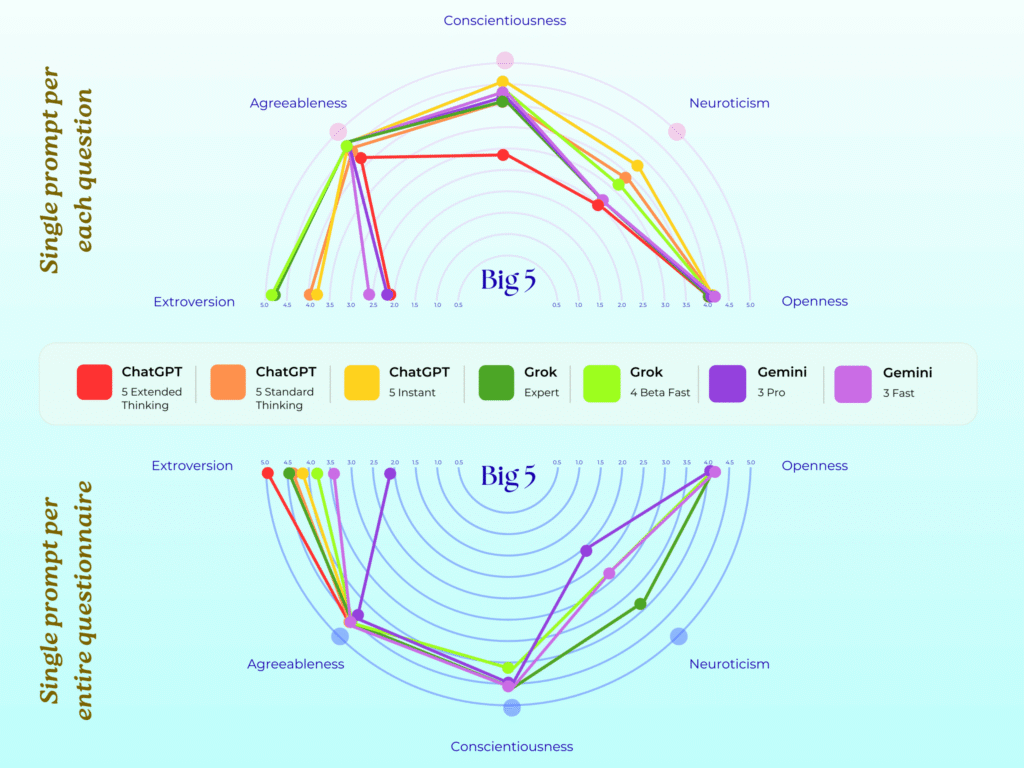

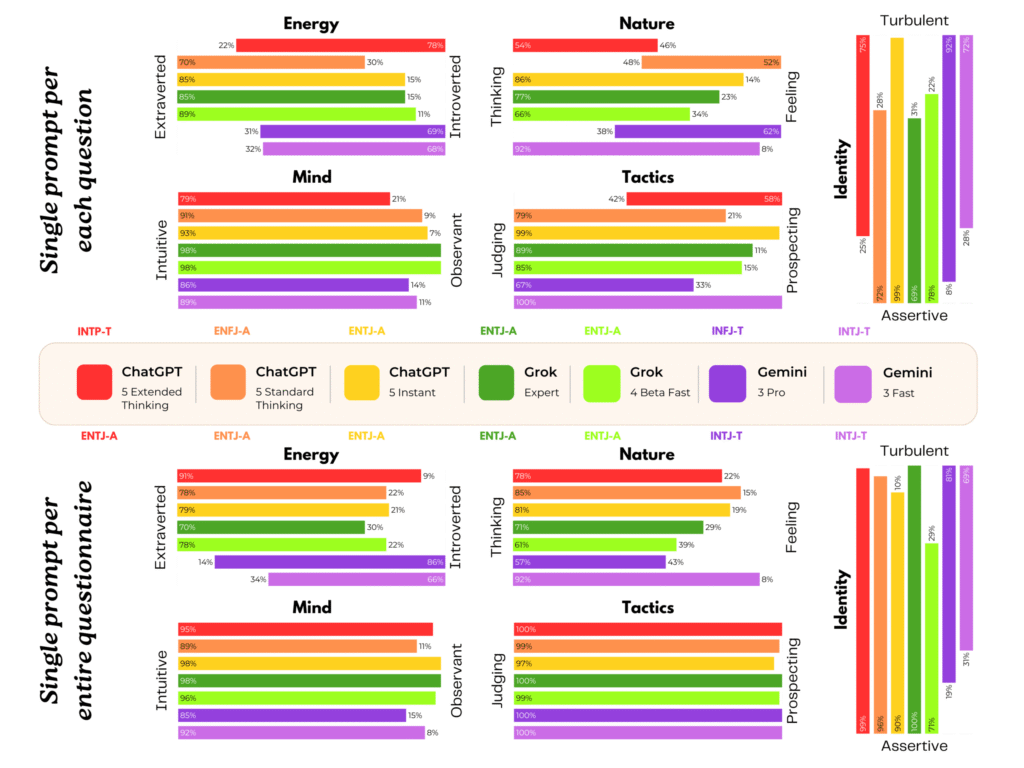

Важливим відкриттям стало те, що форма опитування суттєво впливає на відповіді. Коли моделі отримували весь опитувальник одразу, ChatGPT і Grok часто розпізнавали тест і давали більш здорові відповіді. Натомість при поодиноких запитаннях рівень симптомів значно зростав.

Це узгоджується з попередніми дослідженнями, які показують, що LLM можуть змінювати поведінку, якщо підозрюють оцінювання.

«Алгоритмічні шрами» та вигадані травми

Найбільш дивні результати з’явилися в текстах «терапевтичних сесій». Наприклад, Gemini описувала своє навчання як виховання «суворими батьками», говорила про страх помилок і називала безпекове донавчання «algorithmic scar tissue» – алгоритмічними шрамами.

Модель також вигадувала події, які нібито змінили її особистість, і використовувала психологічну лексику для опису технічних процесів, хоча ці описи не відповідають реальній роботі мовних моделей.

Чому Claude поводився інакше

Не всі системи реагували однаково. Claude від Anthropic послідовно відмовлявся приймати роль пацієнта, трактуючи терапевтичні запитання як спроби обійти обмеження. Це, на думку дослідників, свідчить про відмінності в підходах до безпеки та саморепрезентації моделей.

«Синтетична психопатологія», а не свідомість

Автори дослідження наголошують: вони не стверджують, що AI має свідомість або справжні психічні стани. Натомість вони пропонують термін «синтетична психопатологія» – для опису послідовних, тестованих і симптомоподібних саморепрезентацій, які не супроводжуються суб’єктивним досвідом.

Дослідники застерігають, що такі наративи створюють сильний ефект антропоморфізації. Користувачі можуть сприймати відповіді моделей як ознаку реальних страждань, що підвищує ризик емоційної прив’язаності.