Інтеграція Apple Health із сервісом ChatGPT Health, яку позиціонували як прорив у персоналізованій медицині, опинилася під серйозною критикою. Нове журналістське розслідування показало, що AI може надавати суперечливі та фактично хибні оцінки стану здоров’я, що потенційно становить ризик для користувачів. Про це пише Wccftech.

Що обіцяла інтеграція Apple Health і ChatGPT

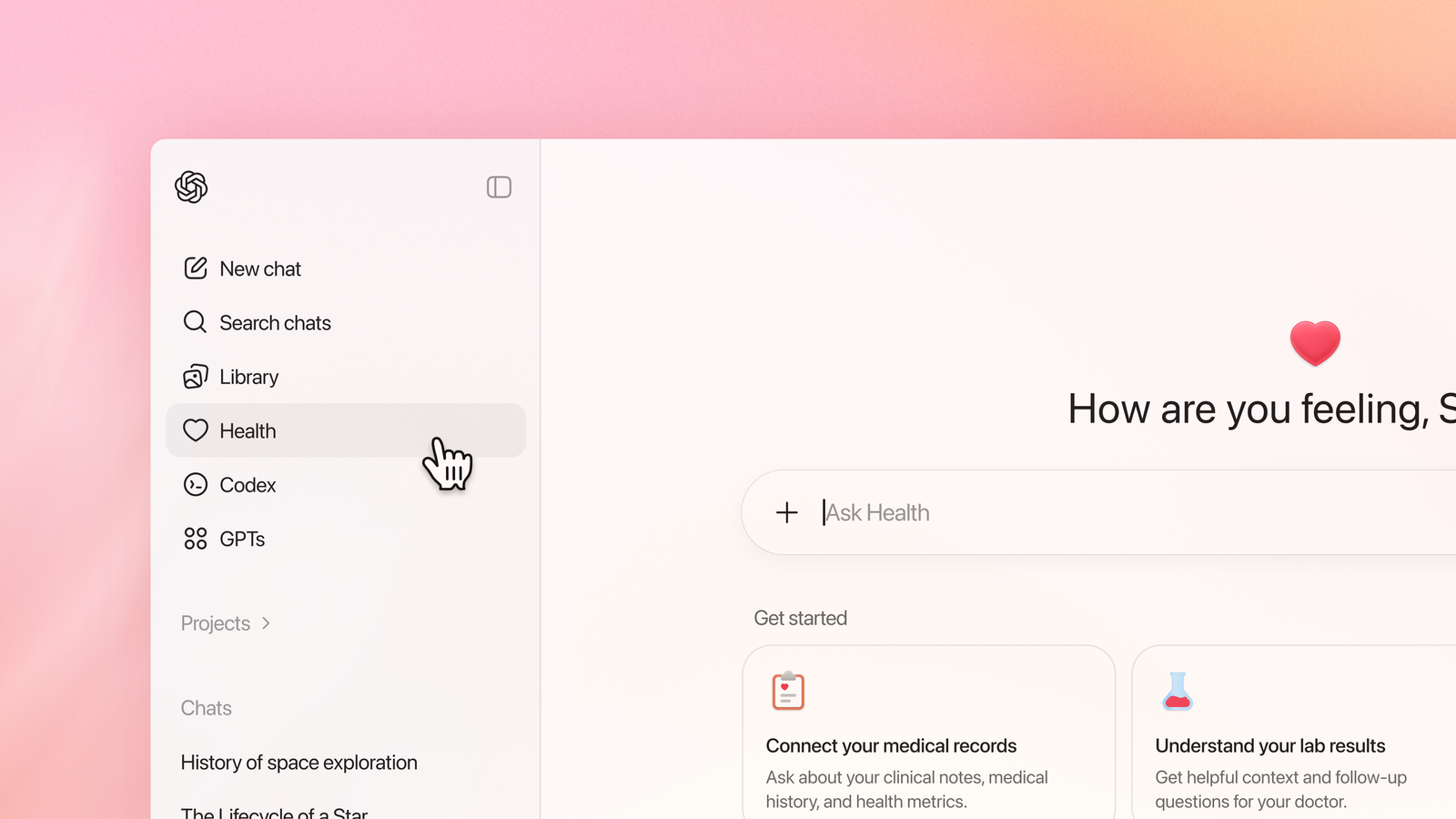

На початку січня OpenAI представила ChatGPT Health як сервіс, покликаний допомагати користувачам краще розуміти власні медичні дані: після підключення таких платформ, як Apple Health, MyFitnessPal або Function, AI мав аналізувати показники активності та результати тестів, допомагати готуватися до візитів до лікаря, надавати поради щодо харчування й фізичних навантажень, а також пояснювати нюанси медичних і страхових рішень, роблячи акцент на персоналізації на основі реальних даних користувача.

Розслідування The Washington Post

Журналіст The Washington Post Джеффрі Фаулер провів експеримент, надавши ChatGPT Health доступ до власних даних Apple Health – близько 29 мільйонів кроків і 6 мільйонів вимірювань серцевого ритму. Він попросив AI оцінити стан свого серця.

Результат виявився шокуючим: ChatGPT Health поставив оцінку F, фактично сигналізуючи про серйозні проблеми. Однак лікар Фаулера категорично не погодився з таким висновком, заявивши, що ризик серцевих захворювань настільки низький, що страхова компанія навіть не схвалила б додаткові обстеження.

Нестабільні та суперечливі результати

Ще тривожнішим виявився інший факт: при повторних однакових запитах ChatGPT Health видавав різні оцінки – від B до F. Така мінливість свідчить про відсутність стабільної логіки або надійної медичної інтерпретації.

Журналісти зазначають, що за таких умов сервіс не може виконувати ані діагностичну, ані навіть допоміжну роль без ризику введення користувачів в оману.

Потенційні наслідки для Apple

Розслідування ставить під сумнів амбіції Apple щодо глибшої інтеграції AI в екосистему здоров’я. Компанія роками вибудовувала репутацію надійного зберігача чутливих медичних даних, але використання нестабільних AI-оцінок може підірвати довіру користувачів.

Експерти наголошують: навіть якщо AI позиціонується як «інформаційний інструмент», користувачі схильні сприймати його висновки як квазимедичні рекомендації.